0898-08980898 13876453617

不少媒体之前已经发了AI年度盘点内容,要挑选出十大成果的话当然需要优中选优。

回顾2021年,无论是人工智能技术还是产业有很多值得称道的研究和落地成果。AI基础理论研究逐步深入,超大规模模型买入万亿参数级别,多模态、无监督学习、强化学习等领域屡有重磅论文发布。此外,在机器学习、自然语言处理、计算机视觉、AI for Science、芯片等领域也有不错的研究引发热烈讨论。

所以我们以下所挑选的基本都是当月也许是最受关注的AI成果,有不少都上了Science或者Nature。不过,从这么多研究中找出十个成果也是件见仁见智的事,你或许有不同的判断,欢迎补充回答。

1月6日,OpenAI发布了推出了两个结合计算机视觉和NLP结合的多模态模型DALL-E和CLIP,它们可以通过文本,直接生成对应图像,对日常生活中的图像和语言有更好的理解。

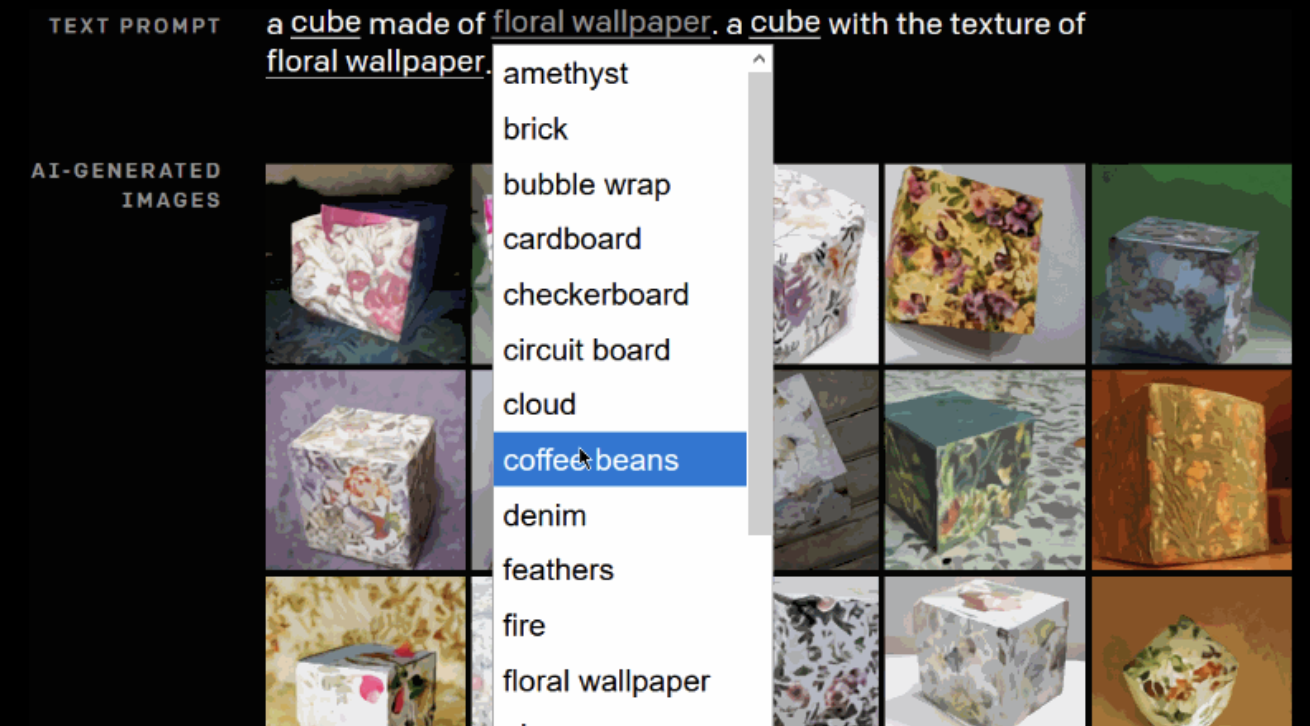

其中,DALL-E使用了GPT-3的120亿参数版本,相比现实世界的图像,生成的图像还原度非常高,同时测试表明,DALL-E也有能力对生成的图像中的物体进行操作和重新排列,也能创造出一些根本不存在的东西。

当然,尽管DALL·E的表现令人惊喜,但也有瑕疵,比如其能够根据描述以各种不同的样式渲染同一场景,并且可以根据一天中的季节或季节来适应光照、阴影和环境,但描述的文本越长,成功率越低,而重复强调关键文本会使成功率提高。

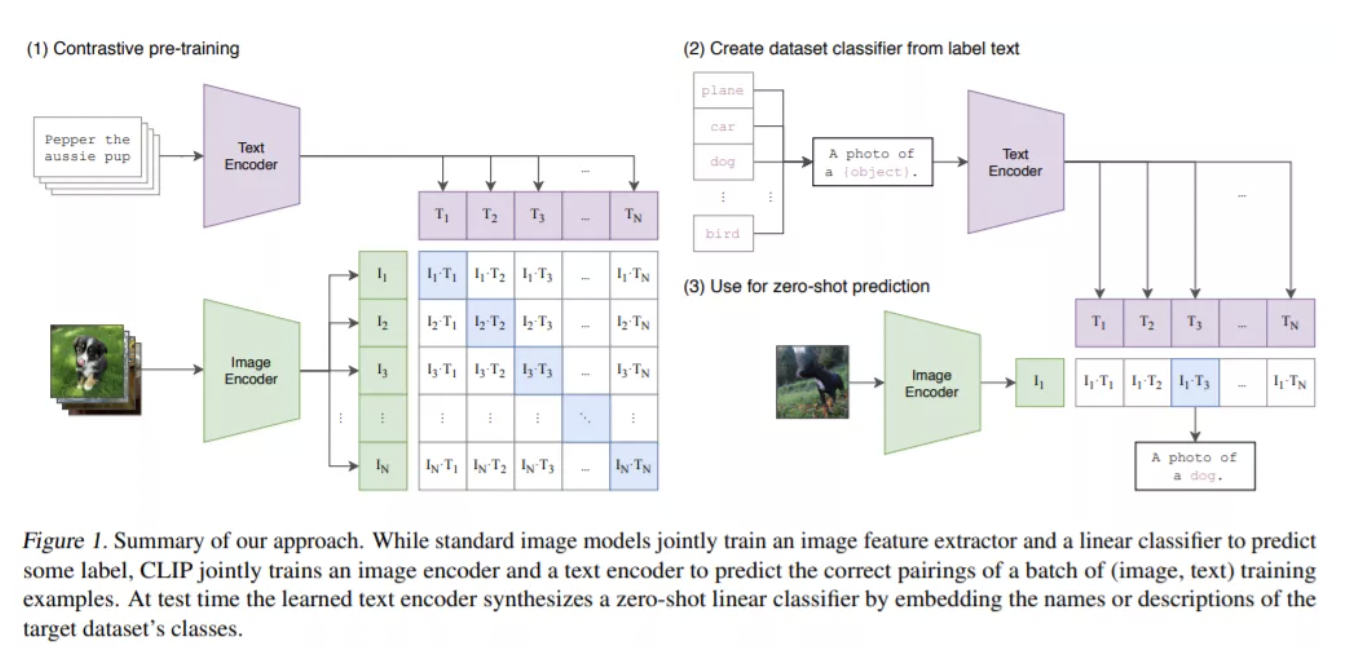

CLIP(Contrastive Language–Image Pre-training)是一个从互联网上收集的4亿对图像和文本来进行训练的多模态模型。与CLIP不同的是,DALL·E被训练于从一段描述中生成图像,以表示自然语言所表达的概念。

CLIP可以从自然语言监督中有效学习视觉概念,可应用于任何视觉分类基准,只需提供要识别的视觉类别的名称,类似于GPT-2和GPT-3的”zero-shot learning”能力。

它使用了丰富的互联网上的与图像配对的文本,这些数据被用来为CLIP创建一个训练任务,然后使用结果将CLIP转换为zero-shot分类器。最后,它将一个数据集的所有类别转换成文字 ,并预测文本的类别与给定图像的最佳对应关系。

CLIP:https://openai.com/blog/clip/

DALL·E:https://openai.com/blog/dall-e/

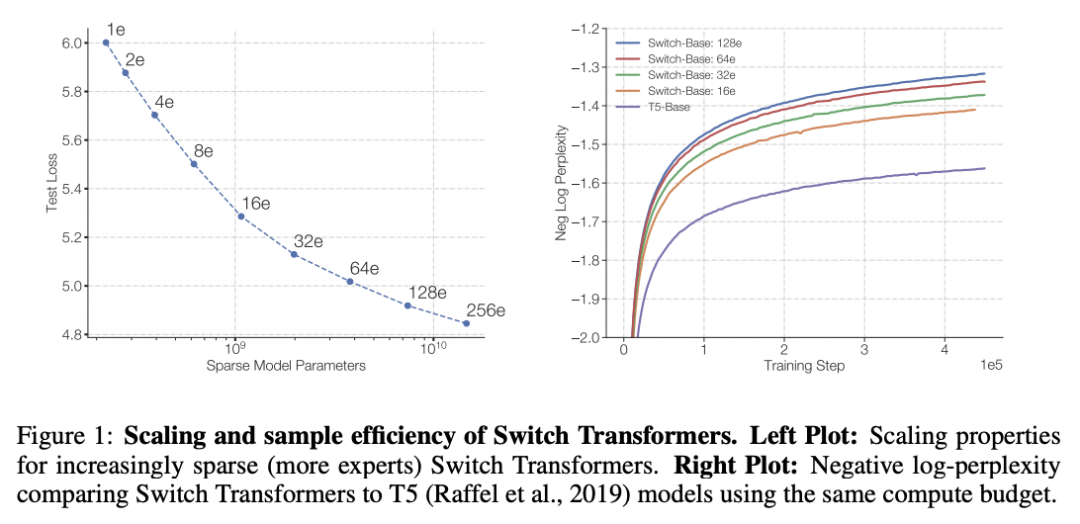

2月17日,距GPT-3问世不到一年的时间,谷歌大脑团队就推出了业界首个1.6万亿个参数的超级语言模型Switch Transformer,在计算资源相同情况下,它比之前由谷歌开发最大的语言模型T5-XXL足足快了4倍,比基本的T5模型快了7倍。研究人员指出,大规模训练是通向强大模型的有效途径。

论文:https://arxiv.org/pdf/2101.03961.pdf

值得一提的是,Transformer 作为一种具有优势的神经网络算法架构,在GPT-3问世后,掀起了采用Transformer架构进行自然语言处理研究的热潮。但如今,在计算机视觉、强化学习、图神经网络等领域逐渐渗透, 展现出人工智能多学科领域通用架构的可能性。尤其在计算机视觉领域,Transformer已成为重要网络架构。

今年,大量基于Transformer架构的网络涌现,比如微软亚研的Swin Transformer获ICCV 2021最佳论文,并开源了代码和预训练模型,涵盖图像分类、目标检测以及语义分割任务。此外,华为诺亚实验室研究者提出了基于Transformer的TNT视觉架构。

论文:https://arxiv.org/pdf/2103.14030.pdf

项目:https://github.com/microsoft/Swin-Transformer

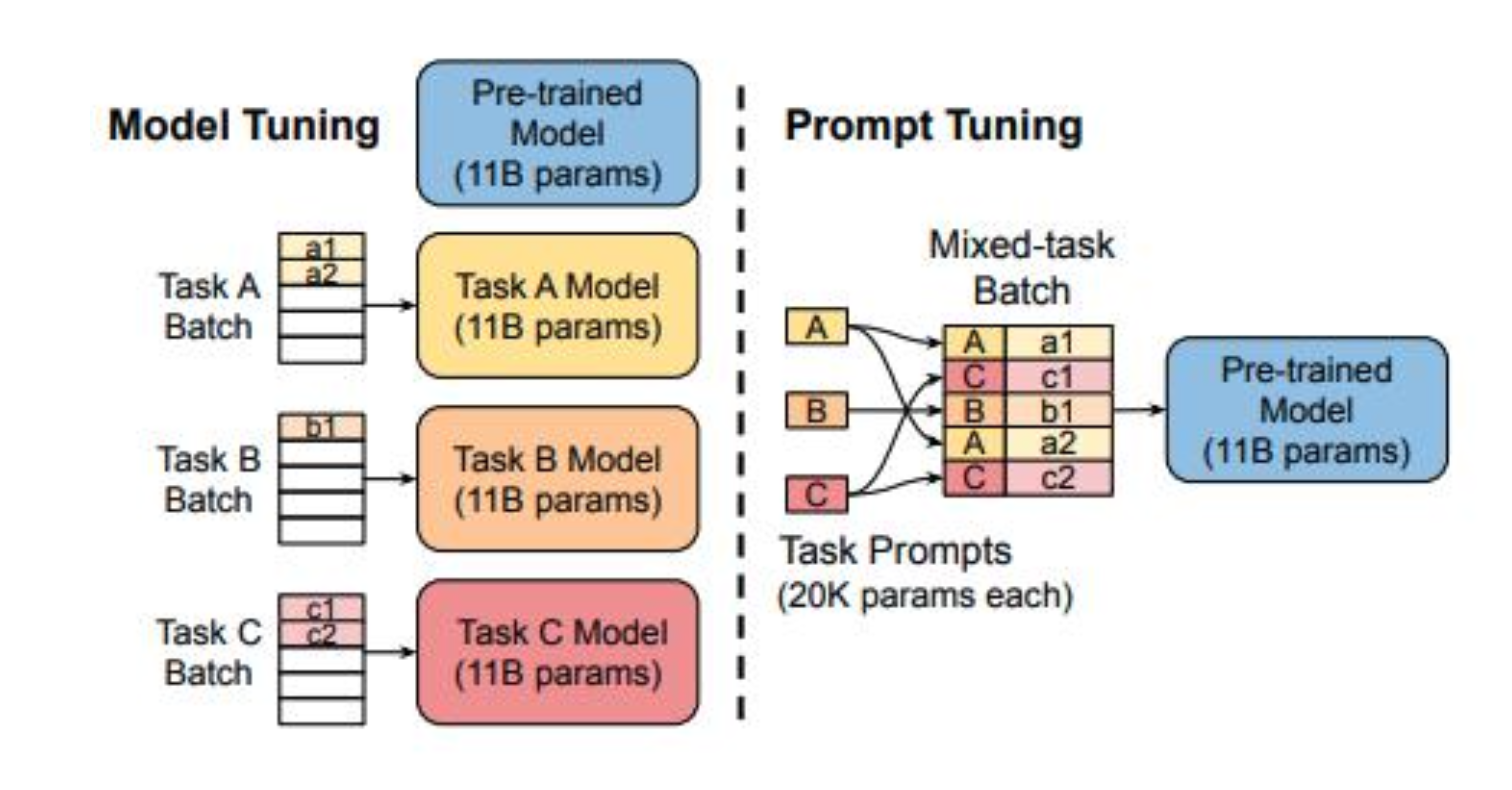

2018年以来,预训练模型的体量不断增大,如T5、GPT-3、悟道等,大模型成为NLP领域 一项非常重要的技术突破。但是,预训练模型精调过程中所需的硬件和数据需求也在不断增长,丰富的下游任务也使微调阶段的设计更为复杂。

为了解决这些问题,新型的“预训练-精调”正在快速发展,其中Prompt Tuning等方法已经崭露头角,成为当前的研究热点。 4月,Google研究团队发布了相关论文https://arxiv.org/pdf/2104.08691

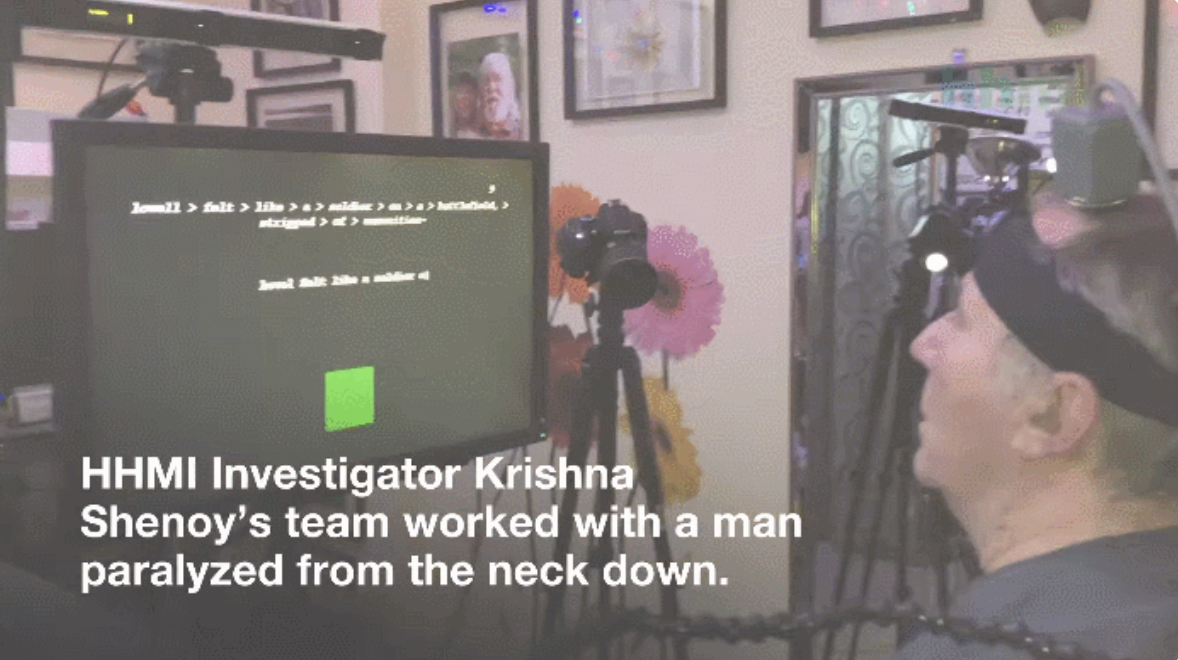

5 月,斯坦福大学的研究者提出了一种新型的脑机接口系统,采用循环神经网络,能够将来自 运动皮层的手写字脑电信号解析为文字。

这项研究结果显示意念写字速度破纪录,写字速度能达到每分钟90个字符,原始准确率为94.1%。在有自动纠错软件的支持下,内容正确率进一步提高到99%以上,远超其他脑机接口的意念写字速度。这项研究可以说首次破译了“与手写笔迹相关”的大脑活动,可以让瘫痪患者不用手也能快速打字。

论文:https://www.nature.com/articles/s41586-021-03506-2

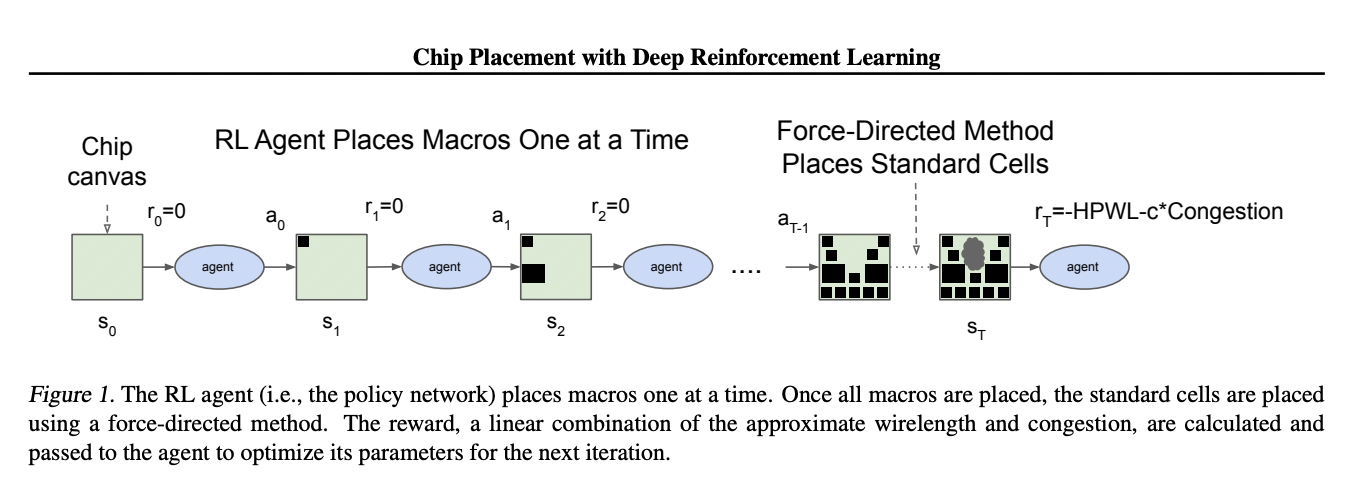

2020年4月,谷歌大脑研究者Jeff Dean等提出了一种基于 AI 的芯片设计方法。该方法可以在6小时内完成设计工作,而人类需要数周时间。https://arxiv.org/pdf/2004.10746.pdf

今年6月,谷歌联合斯坦福大学的研究者对这一方法进行了改进,并应用于下一代AI加速芯片的设计中。该方法可自动生成的芯片布局设计,并在功耗、性能和芯片面积等关键指标上媲美人类工程师。目前该研究已发表于 《自然》杂志上。

论文:https://www.nature.com/articles/s41586-021-03544-w

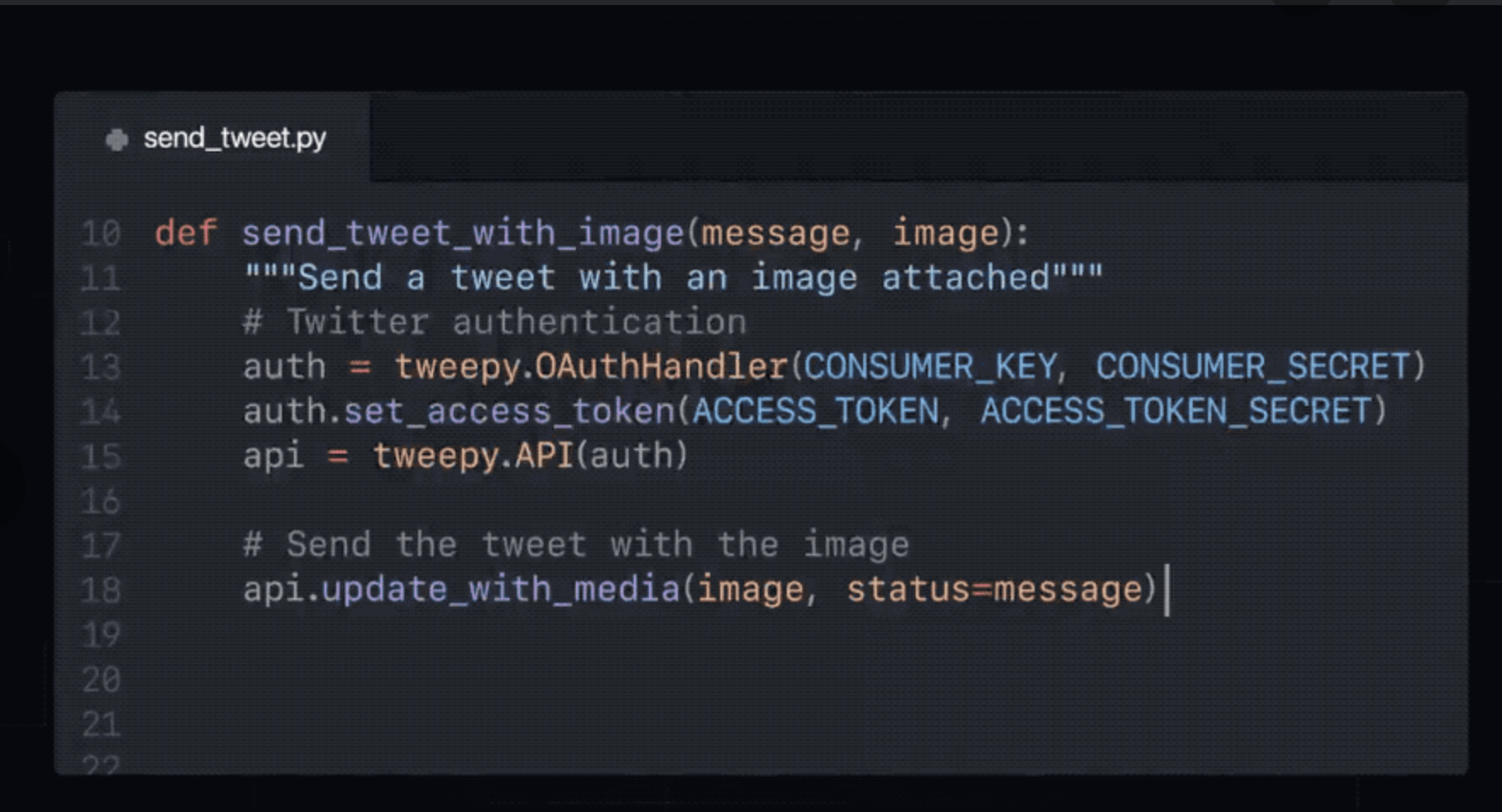

6月30日,OpenAI联合微软、GitHub推出了基于大规模预训练语言模型研发的Copilot代码生成插件,能够集成在微软的编辑器VS Code 中。Copilot经过数十亿行公开代码训练,它能从注释和代码中提取上下文,并能立即为人类程序员写的代码和整个函数提供自动代码生成的建议。

Copilot 主要可以辅助三种开发任务,包括代码生成、代码补全、测试用例生成等。由于基于“大参数+大算力”进行训练,Copilot具有非常惊人的性能,一些评论甚至认为Copilot带来了一种新的代码开发模式。 链接:https://?copilot.github.com ?

7月23日,在开源AlphaFold2仅一周后,DeepMind再次在《自然》杂志发文,AlphaFold数据集的发布引爆科研圈:数据集中预测的所有氨基酸残基中,有58%达到可信水平,其中更有35.7%达到高置信度。而在这之前科学家们数十年的努力,只覆盖了人类蛋白质序列中17%的氨基酸残基。

此外,AlphaFold已经预测出了350000种蛋白质结构,涵盖了98.5%的人类蛋白质组以及20种生物的蛋白质,例如大肠杆菌、酵母菌和果蝇等,可通过公布的数据库查看各个蛋白质的3D结构。

论文:https://www.nature.com/articles/s41586-021-03828-1

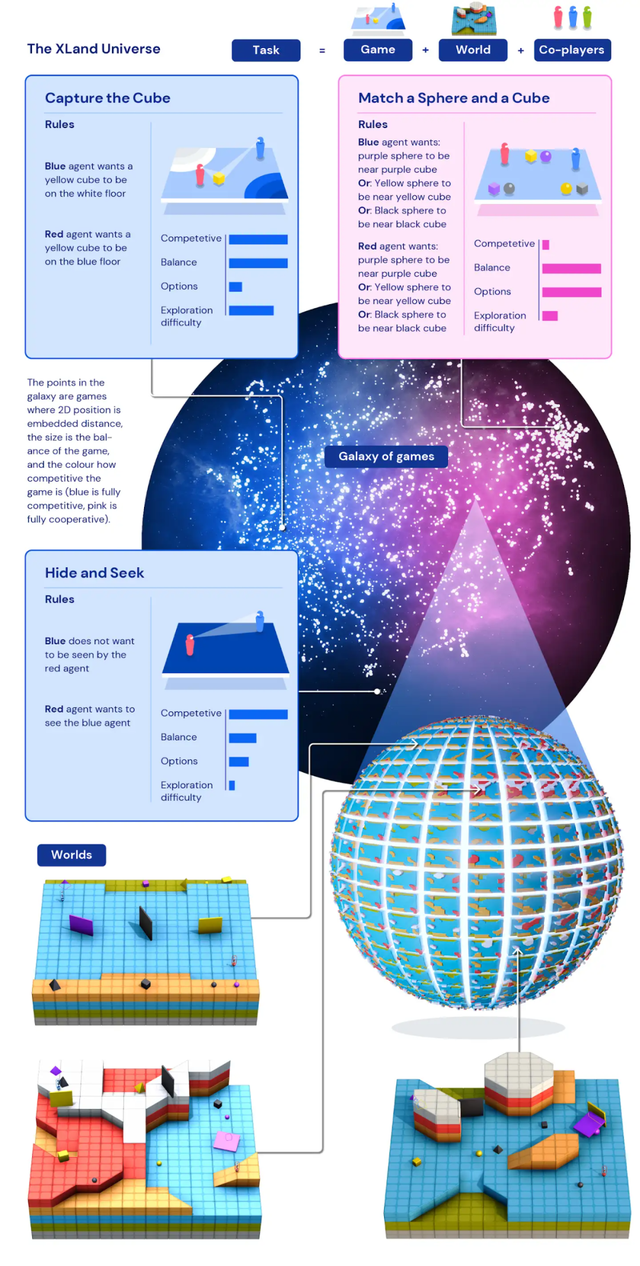

7 月,DeepMind 研究者提出一种名为XLand的通用智能体强化学习训练环境。DeepMind 认为,泛化能力不足是限制当前强化学习算法应用的一大障碍。但泛化能力并不是一蹴而就形成的,人类是从简单的任务开始,逐渐掌握复杂的任务。

受此启发,DeepMind提出一个由任务空间组成的、超大规模的“元宇宙”XLand,它能让智能体在不断扩展、升级的开放世界中通过上亿次的训练练就了不俗的泛化能力,其中包含了数十亿个任务,涵盖雅达利、夺旗、Dota2、捉迷藏等不同的游戏、世界和玩家对象。AI智能体首先学习简单任务,不断完善,然后逐渐在更为复杂的任务上训练。

经过5代训练,AI智能体在XLand的4000个独立世界中玩大约70万个独立游戏,涉及340万个独立任务的结果,最后一代的每个智能体都经历了2000亿次训练步骤。目前,AI智能体已经能够顺利参与几乎每个评估任务。

链接:https://deepmind.com/blog/article/generally-capable-agents-emerge-from-open-ended-play

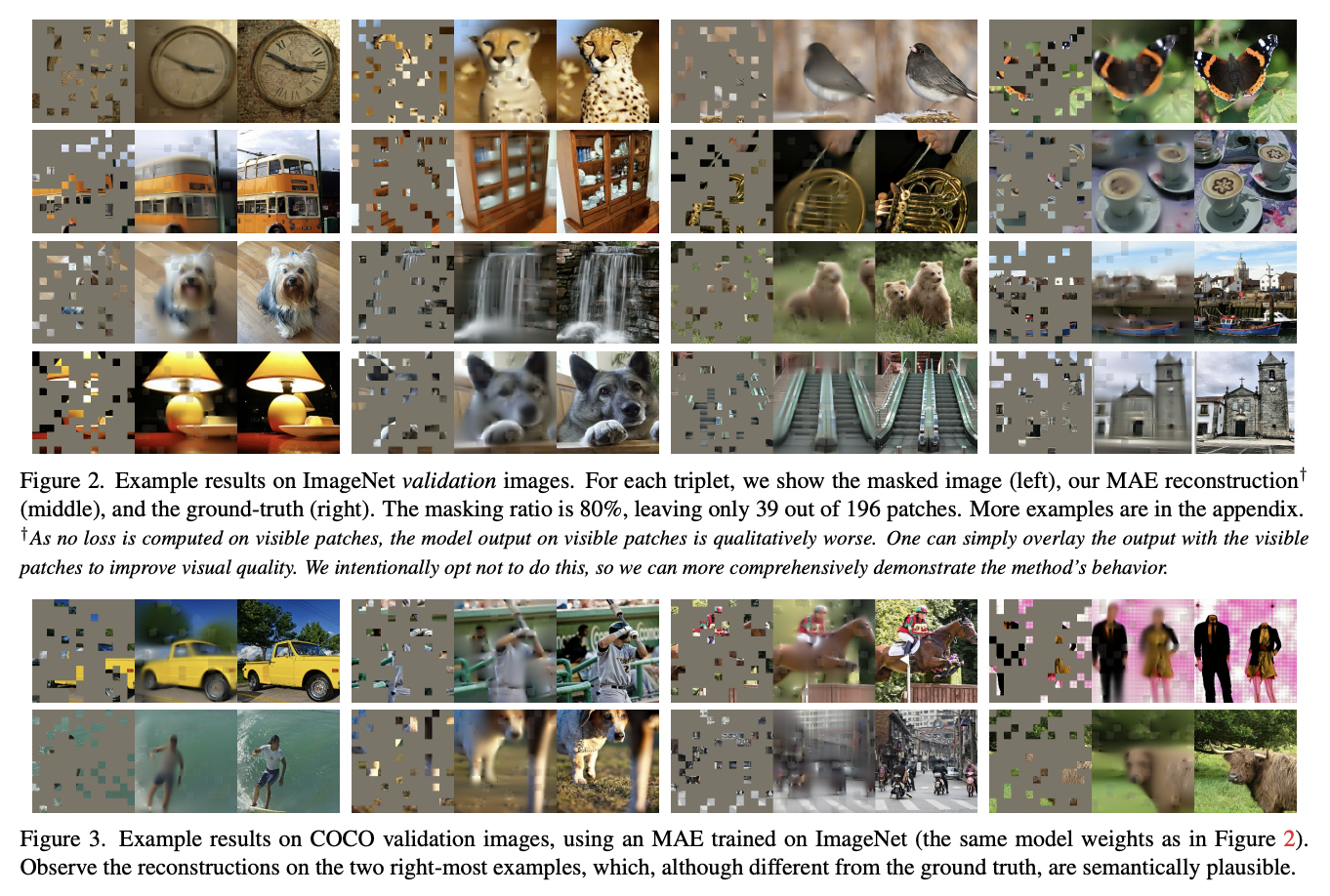

2021年11月,何恺明担任一作的Facebook AI实验室提出一种用于计算机视觉的可扩展自监督学习方案Masked AutoEncoders(MAE),代表了无监督,弱监督在视觉领域的进展。他所提的MAE极为简单:对输入图像的随机块进行mask并对遗失像素进行重建。

它基于以下两个核心设计:一是设计了一种非对称编解码架构,其中解码器仅作用于可见块(无需mask信息),而解码器则通过隐表达与mask信息进行原始图像重建;其次,他们发现对输入图像进行高比例mask(比如75%)可以产生一项重要且有意义的自监督任务。

MAE方案使得所得高精度模型具有很好的泛化性能:仅需ImageNet-1K,ViT-Huge取得了87.8%的top1精度 。下游任务的迁移取得了优于监督训练的性能,证实了所提方案的可扩展能力。

论文链接:https://arxiv.org/pdf/2111.0637

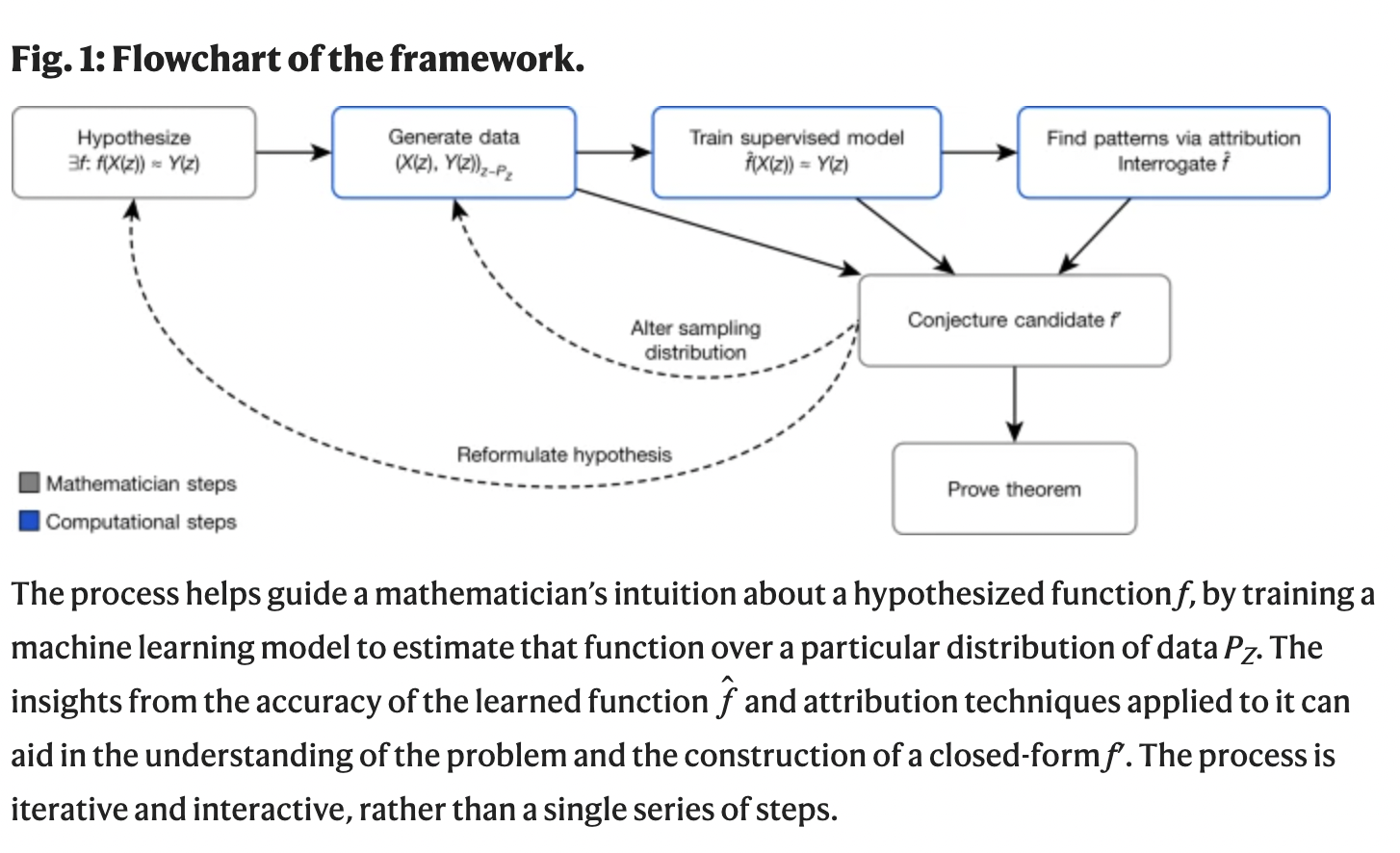

12月,DeepMind 研究者提出采用机器学习辅助发现数学猜想和定理的方法。通过AI技术能够发现数学目标中潜在的模式和关系,理解这些目标之间的属性机理,并帮助数学界寻找直觉和模式。

研究者通过人工智能技术成功帮助数学家进一步解决数学问题。例 如:(1)扭结的代数和几何结构的新关联;(2)由对称群的组合不变性猜想预测出的候选函数。研究者认为,这一研究有助于形成一种数学和人工智能领域之间的协作模式,通过利用两个领域之间的优势,得到更加具有突破性的发现。

论文:https://www.nature.com/articles/s41586-021-04086-x

从上述成果来看,可以看到,那些开创性研究依然是由DeepMind、Google Brain、OpenAI、FAIR等我们耳熟能详的国外知名机构所领衔,国内在大模型、芯片等领域也有不错的研究成果,但在引领性的基础研究方面尚需努力。

更多2021年的AI研究成果,强烈推荐阅读《2021-2022 年度智源人工智能前沿报告》,里面有非常翔实的内容介绍。